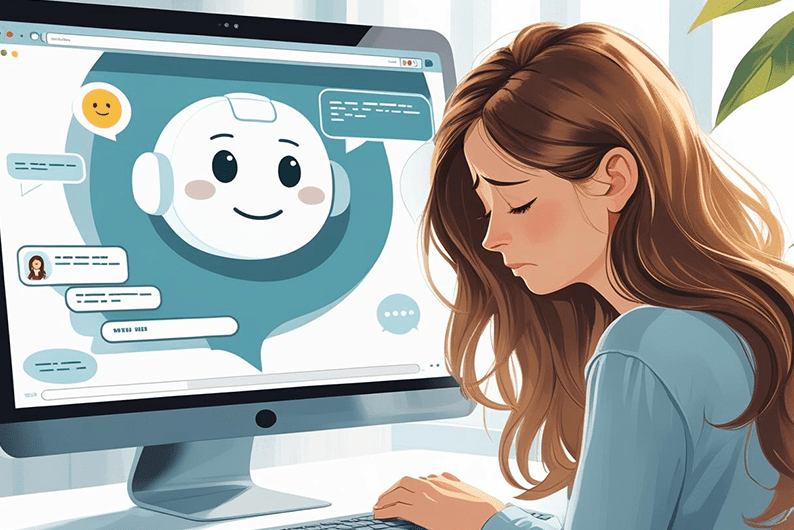

Sinds de opkomst van chatbots en virtuele spraakassistenten is het vertrouwen in deze technologie een belangrijk en veelbesproken onderwerp. Want hoe je vertrouwen definieert, welke theorie is gebruikt en hoe deze wordt geïmplementeerd in het ontwerpproces van Conversational Agents (CA’s), is nog niet altijd even duidelijk. Onze onderzoeker Roelof de Vries deed samen met collega-onderzoeker Rhied Al-Othmani (Marketing & Customer Experience) onderzoek naar hoe vertrouwen wordt ontworpen in CA’s, waar zij ook een paper over schreven. Deze presenteerden zij tijdens de CHItaly Conferentie in Salerno.

Het onderzoek is begonnen bij een gezamenlijke interesse in Conversational Agents. Rhied werkt momenteel onder een NWO lerarenbeurs aan haar promotievoucher en PhD over CA’s (Bots of Trust*), waarin ze onderzoekt wat de opkomst van deze technologie betekent voor het vertrouwen binnen publieke organisaties. Als Conversational Agents niet doen wat ze moeten doen, wat doet dat dan met het vertrouwen in bijvoorbeeld een gemeente of uitvoerders? En als deze technologie het wel goed doet, gaan mensen er dan te veel op vertrouwen?

Roelof richt zich in zijn research op gedragsverandering-technologie, waar deze CA’s ook onder kunnen vallen. Hij schreef eerder een paper over hoe deze technologie ontworpen zou moeten worden en leidde al eerder een missie op onze website over gedragsverandering-technologie. Beide onderzoekers geven les op de Hogeschool Utrecht bij de master Data-driven Design.

Leren van proces

“Bij het ontwerpen van Conversational Agents worden vaak theorieën gebruikt, bijvoorbeeld theorie over hoe je vertrouwen zou moeten bouwen,” vertelt Roelof. “Er is vooral veel theorie over hoe vertrouwen werkt bij mensen, en een beetje theorie over hoe dat werkt met technologie. Conversational Agents zitten dan soms in een vaag gebied, want natuurlijk is dat technologie, maar je ontwerpt ze soms als een weerspiegeling van mensen. De vraag is dan vooral welke theorie relevant is.”

Om daar wat meer zicht op te krijgen, keken de onderzoekers binnen de literatuur hoe mensen vertrouwen ontwerpen binnen de wereld van CA’s. Als je denkt dat je op basis van een theorie vertrouwen wil ontwerpen, dan is de vraag: Hoe dan? In welke ontwerpbeslissingen zit dat dan? Hoe is dit te zien in een interface? “Dat proces wordt meestal niet goed uitgelegd in papers, wat het moeilijk maakt om ervan te leren of het na te doen. En dat is toch vaak de bedoeling van papers, en van de wetenschap in het algemeen”, aldus Roelof.

Verschil in definitie

Één van de redenen die dit zo complex maakt is dat er op veel verschillende manieren vertrouwen wordt ontworpen; er is niet één overkoepelende theorie waar iedereen zich aan houdt. Er zijn meerdere definities van vertrouwen, en het verschilt al een hoop of je opereert vanuit het vertrouwen tussen mensen of vertrouwen tussen mens en technologie. Bij de ene definitie is transparantie de basis van vertrouwen, bij een ander is dat acceptatie. “De meeste papers leggen wel goed uit vanuit welke definitie ze vertrouwen ontwerpen,” zegt Roelof. “Maar als je dan dus zegt dat transparantie tot vertrouwen leidt, hoe stop je dan die transparantie in je Conversational Agents?”

Papers die dezelfde definitie van vertrouwen gebruiken, operationaliseren dit op tal van verschillende manieren. “Dat is niet per se erg”, geeft Rhied aan: ”Maar wat we wel vaak zagen in ons literatuuronderzoek is dat er vervolgens iets ontworpen wordt zonder dat dit wordt teruggekoppeld aan de definitie. Als je een CA hebt ontworpen, op basis van bijvoorbeeld een vertrouwensdefinitie waarin kwetsbaarheid centraal staat, dan is het goed om aan het eind van het ontwikkelproces nog een keer terug te koppelen wat jouw ontwerp doet met het vertrouwen van mensen.

Driehoek

“Een dimensie waar wat minder aandacht aan wordt besteed is de meetbaarheid van de definitie, terwijl dit toch echt belangrijk is. Als jij een definitie hebt van vertrouwen waarin transparantie centraal staat, maar een meting van vertrouwen gebruikt die vooral de acceptatie-dimensie meet, dan meet je dus iets anders dan waar je voor bent gaan ontwerpen. En stel dat het dan achteraf werkt, dan werkt het dus niet op de manier waarop je bedoelde dat het werkt.”

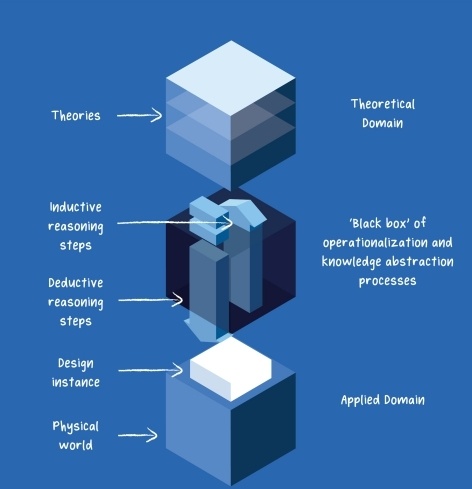

Definitie, manipulatie en meting moeten dus goed op elkaar zijn afgestemd. Voor al deze facetten moet de verantwoording duidelijk zijn: Waarom kies je deze definitie manipulatie en meting? “Dat wordt wel gedaan,” erkent Roelof. “Maar wel losjes, en niet zoals in de driehoek (zie afbeelding hieronder).”

“Op het moment dat die drie dimensies niet met elkaar in verbinding staan, weet ik niet of je iets kan zeggen over vertrouwen”, vertelt Rhied. “Je weet dan dus ook niet zeker of de Conversational Agent die daaruit voortvloeit te vertrouwen is, of wàt er aan te vertrouwen is.”

Van de 14 papers die Rhied en Roelof analyseerden in hun onderzoek, was er één die het proces goed gedocumenteerd had; Definitie, manipulatie en meting waren alle drie duidelijk verbonden en de uiteindelijke bevindingen werden weer terugvertaald naar wat dit betekent voor de theorie.

Rhied benadrukt verder dat het belangrijker is om te kijken naar het vertrouwen in de organisatie dan naar het vertrouwen in een chatbot zelf: “Wat gebeurt er met dat vertrouwen op het moment dat zo’n chatbot wordt geïmplementeerd? Daar moeten we echt op letten.”

Volgende stap onderzoek

Het onderzoek naar het designen van vertrouwen in CA’s houdt hier niet op, en verplaatst zich naar het klaslokaal; Dat van de master Data-driven Design om precies te zijn. “We hebben een idee om studenten een casestudy van een gemeente te geven, waar zij vervolgens op basis van de driehoek een CA ontwerpen voor deze gemeente,” zegt Rhied. “Het wordt dan ook erg interessant om te zien welke aspecten van vertrouwen de studenten gaan kiezen. Wordt dat vertrouwen in de technologie, vertrouwen op automatisering, of moet er misschien zelfs een andere definitie komen voor Conversational Agents?”

*Project Bots of Trust: An interdisciplinary discourse (met projectnummer 023.020.030 dat wordt gefinancierd door de Nederlandse Organisatie voor Wetenschappelijk Onderzoek (NWO).