Tag: #Afgeronde Missies

Missie 10: Recommender systemen, de mens en AI hand in hand

In de tijd dat je opstaat en op je werk aankomt, heb je al met een scala aan recommender systemen te maken gehad. Een muziekdienst om een kickstart aan je dag te geven, een gepersonaliseerde nieuwsfeed die je op de hoogte houdt van wat je interesseert en zelfs een app als Google Maps die je de handigste route naar kantoor voorschotelt met live-updates over het verkeer. Recommender systemen zijn overal, maar de controle die je erover hebt als gebruiker is minder in beeld.

Daar willen we met Missie 10: Recommender systemen, de mens en AI hand in hand verandering in brengen. Het onderzoek gaat over hoe je de gebruiker weer een beetje die macht terug kan geven. Als je een gebruiker weer wat meer controle geeft over het algoritme, zoals zelf kunnen kiezen welke aspecten van een recommender systeem belangrijk zijn, kun je samen met de artificiële intelligentie tot betere aanbevelingen komen.

In de video hieronder leggen we alles uit.

De vraag achter Missie 10: Recommender systemen, de mens en AI hand in hand

De belangrijkste vraag die wij hebben is op welke manier kun je gebruikers controle geven over het algoritme en welk effect heeft dat op hun gebruikerservaring? Stel dat je op een dating app zit. Je hebt allemaal gegevens ingevuld en er komen dan allemaal potentiële matches voor je uit, maar misschien passen die niet helemaal bij wat je verwachtte. Als je geen enkele controle over het algoritme hebt, moet je daar gewoon mee doen.

Als je een heel klein beetje controle hebt over het algoritme, dan kun je bijvoorbeeld instellen dat je het belangrijk vindt dat ze een hoge opleiding hebben gehad of in de buurt wonen of van honden houden. Je vindt dan bepaalde dingen belangrijker dan de dingen die het algoritme nu dacht dat belangrijk waren.

Wil je op de hoogte blijven van onze nieuwste video’s, podcasts en artikelen? Volg ons dan op LinkedIn en Youtube.

Hou de komende tijd ook de website in de gaten, want wij zijn zeker van plan de komende tijd meer te publiceren over dit onderzoek!

De producties voor deze missie worden ondersteund door redacteur Luuc ten Velde.

Missie 9: Outside looking in

Recently, a group of students were talking about AI misgendering black women and being unable to identify Asian people. They remarked: “Maybe these functions weren’t intended for them, so they shouldn’t complain.” To say that I was shocked is an understatement. How could they think that?

Six months before, another group of students and I discussed the term ‘Data Bias’, and the effects of it in our society. I was surprised to learn that most of them did not seem to care much, as they didn’t identify with being excluded. I asked the students to create user profiles and all their intended and expected users were “white”, ‘male’, ‘able-bodied’, ‘educated’ and ‘employed’, a complete mismatch with the students in my classroom.

Why was this happening? I learned that most interpretations of diversity and inclusivity don’t seem to cover the true breadth and depth of these terms, which poses a problem when designing software that’s meant to be inclusive. One has to wonder, how can you be inclusive when you don’t know who you are trying to include?

At HEMD, one of the things I focus on is designing conversational tools for sensitive topics such as mental health issues, sexual abuse, maternal and child healthcare. These are systems that are very sensitive to their users’ needs, which may vary based on age, race, gender, cultural backgrounds, religious beliefs, sexual orientation, physical and mental ability, socio-economic status and literacy level. And the list goes on.

You’re right, that’s a lot of parameters to consider. And yes, designing inclusive systems can be more difficult than designing systems that simply don’t take these things into account. But the consequences of designing systems that don’t connect with their audience – or rather, failing to design systems that do – can be very painful.

For instance, many services vital for life in the Netherlands – government websites, health insurance, online banking – lack other language options. Leaving me lost in my work and daily life. Some days I think if it weren’t for Google Translate, I would’ve signed away my right to live. I don’t understand half the information I’m supposed to, because despite up to 2.5 million people not speaking Dutch ‘adequately’, very little is being done to facilitate them.

Thus, we come to the topic of the mission we’re introducing today. The question of ‘how can you minimise exclusion through design?’

The words used there were chosen very carefully. Because there are, in fact, legitimate reasons to design things with a specific target audience in mind. We’ll get into that topic another time. The point is: Whatever you design should not exclude users interested in using your product.

We want to find out what prevents users from connecting with both digital and physical spaces and products, and find out what can be done to improve their design to be more in line to the needs of its users. We want to look at who is doing it right and where mistakes are being made, as well as how to prevent them.

I’m undertaking this mission and the research backing it with Marissa Berk, one of my colleagues at HEMD who you might have met previously in the presentation about the GDPR tool that HEMD developed. She also has a background in user-centered and data-driven design, and we’ll be working together closely throughout the process.

One of the major challenges for the project will be to find a group that is diverse enough to provide us with the variety of perspectives that we want to consider. It’s easy to claim to be inclusive, but to actually test your designs with a user base that is not just diverse in gender, ethnicity, and religion but also in educational background, income level, mental health, age, sexual orientation, physical and mental capabilities, linguistic skills (and more), can be extremely difficult. The list of different types of people is never-ending, and so identifying what characteristics influence which aspects of user experience will be an important piece of the puzzle.

There’s a lot of things that aren’t yet set in stone, and our next steps will be to talk to other researchers and designers working on this topic, to see what things they might be struggling with.

We hope you will join us in the coming months as we explore this topic further. Follow us on LinkedIn and Youtube to stay up to date with our latest releases, and of course, don’t forget to keep an eye on our website either.

De producties voor deze missie worden ondersteund door redacteur Sander van Velze.

Missie 8: Mijn vriend de robot

Er worden steeds meer chatbots en robots gebruikt in de publieke sector. Kinderen en tieners komen in het onderwijs en de zorg in toenemende mate in contact met bots. De kunstmatige ‘buddies’ kunnen worden gebruikt om te leren rekenen, maar kinderen willen soms ook hun hart bij hen kunnen luchten. Daarom wordt het steeds belangrijker dat deze bots menselijke eigenschappen kunnen vertonen zoals empathie, contextbewustzijn en vriendelijkheid.

Deze eigenschappen worden samengevat als ‘pedagogische fijngevoeligheid’: het vermogen om de emotionele behoeftes van de gesprekspartner te herkennen, daar empathisch op te reageren, zonder een oordeel te vellen, en het kind het gevoel te geven dat ze ‘gezien worden’.

Dat geheel is natuurlijk heel lastig, want dat is niet voor iedereen hetzelfde. Zelfs mensen hebben hier vaak genoeg moeite mee, terwijl wij jarenlang zijn opgevoed om alle subtiele signalen te herkennen. Als iemand jou vertelt dat hun kat is overleden, begrijp je heel goed dat ze daar verdrietig over zijn: dat is immers ‘logisch’. Maar een robot kent die ‘logica’ niet. Die logica is ons aangeleerd. Dus een robot snapt dat als jij zegt dat je verdrietig bent je verdrietig bent, maar die mist het begrip dat het overlijden van je huisdier je ook verdrietig maakt, als je dat niet expliciet vertelt. Ze kunnen wel reageren, maar ze begrijpen de context en subtekst niet.

Nieuwe toepassingen, nieuwe wensen

Historisch zijn robots en chatbots vaak ingezet in functionele, commerciële toepassingen waar dit soort fijngevoeligheid niet relevant is voor hun taak. Als jij tegen de klantenservice vertelt dat je product kapot is, stuurt de chatbot jou een retourformulier. Daar komt niet heel veel empathisch vermogen bij te pas. En dat is ook niet nodig, want je hoeft geen langdurige relatie op te bouwen met een klantenservice-chatbot.

In de klas is dat anders. Om robots daar effectief in te kunnen zetten, is het namelijk nodig dat kinderen daar wél langdurig mee aan de slag gaan. En om dat langdurige contact mogelijk te maken, is het nodig dat de kinderen die robots niet zien als een ‘iets’, maar als een ‘iemand’. Zoals we allemaal weten, verdwijnt ‘iets’ namelijk altijd op ten duur in de kast als de nieuwigheid er af is. Maar als het kind een band opbouwt met de robot, dan, net als met hun favoriete knuffel, willen ze er vaker mee interacteren. En hoe vaker dat kind in aanraking komt met de robot, hoe effectiever die is als leermiddel.

Enerzijds moet er dus relatievorming plaatsvinden met als primair doel dat een kind blijft interacteren met de robot, anderzijds is die relatievorming ook essentieel als je wilt dat een kind zich kwetsbaar op durft te stellen naar de robot. Hoe je dat bereikt is het onderwerp van het onderzoek van mijn collega Shakila Shayan. Zij onderzoekt hoe je chatbots zo kunt ontwerpen dat zij op een genuanceerde manier empathisch kunnen overkomen, wetende dat authentieke empathie niet te programmeren is.

Onze doelstelling

De grote vraag is dus: hoe stimuleer je als ontwerper relatievorming tussen bots en kinderen?

Sinds juli ben ik samen met andere onderzoekers en praktijkpartners bezig geweest met het ontwikkelen van een ‘opportunity map’: een overzicht van de belangrijkste inzichten, met als doel andere betrokkenen in het onderwijs te motiveren om de belangrijkste ontwerpfactoren voor relatievorming verder te ontwikkelen, testen en in de praktijk toe te passen.

Deze opportunity map is ten tijde van het schrijven bijna af. Maar zo’n opportunity map is natuurlijk maar het begin. We weten wát er potentieel belangrijk is, maar je moet het wel kunnen meten om definitief vast te kunnen stellen welke factoren in welke context effectief zijn bij welk kind. Dat zijn een hoop variabelen, maar die zijn wel nodig om een correct en volledig beeld te krijgen. Het ene kind heeft een grotere fantasie dan een ander, is meer of minder nieuwsgierig of heeft andere zorgen die relatievorming in de weg staan.

Wij vinden het belangrijk dat deze factoren wél worden meegenomen in metingen van de effectiviteit, en dus hebben wij een vragenlijst ontwikkeld om die factoren meetbaar te maken. Deze vragenlijst zijn we nu in de praktijk aan het testen. Daarna volgt het grotere doel: een onderzoek waarin we spelen met de eigenschappen van de robot die volgens ons gevolgen hebben voor de relatievorming met de kinderen, en kijken welke gevolgen die aanpassingen hebben op de band tussen robot en kind.

De komende tijd gaan wij ook in gesprek met software en AI-ontwikkelaars, leraren, kinderen, academici en andere betrokkenen om meer achtergrond te bieden over bots en relatievorming.

Het uiteindelijke doel van ons onderzoek, de tests en gesprekken die we willen hebben met allerlei betrokkenen, en de missie in het geheel, is designers enthousiast te maken over de toekomstige mogelijkheden, en hen houvast te geven bij de ontwikkeling van bots die betekenis en impact hebben voor en op de gebruikers. Graag neem ik jullie mee in dit onderzoek, dan zien we samen welke mogelijkheden er worden gecreëerd door onze kunstmatige compagnons.

Wil je op de hoogte blijven van onze nieuwste video’s, podcasts en artikelen? Volg ons dan op LinkedIn en YouTube!

Hou de komende tijd ook de website in de gaten, want wij zijn zeker van plan de komende tijd meer te publiceren over dit onderzoek!

De producties voor deze missie worden ondersteund door redacteur Remi Terhorst

Missie 7: Grip op de AVG van je game

Wat als je als gameontwikkelaar eenvoudig zelf in een half uurtje kunt zien of je ontwerp van je game voldoet aan de eisen die de AVG stelt aan je game?

Een deel van de Nederlandse gameontwikkelaars en ontwerpers houdt zich bezig met het bouwen van serieuze games. Ze realiseren zich heel goed dat bij het gebruik van data de AVG om de hoek komt kijken en wat de financiële gevolgen zijn van het niet goed toepassen van de AVG. Maar wat precies de regels zijn, daar houdt de kennis over het algemeen op.

Het dilemma van de AVG-wetgeving

Wij kennen in Nederland overwegend ontwerpers en ontwikkelaars die werken voor een kleine studio of die als zelfstandig ondernemer aan het werk zijn. Vaak is er onvoldoende interne kennis in huis en ontbreekt er financiële ruimte om expertise op het gebied van AVG in te kopen in het ontwerpproces van de game. De ontwikkelaar die besluit zich te verdiepen in de AVG-wetgeving wordt ontmoedigd door de strikte complexe regels geschreven in juridisch vakjargon.

Dit betekent dat in de praktijk bij het bouwen van een game het balanceren is tussen wensen van de opdrachtgever, mogelijkheden van de game en de gevoelde beperkingen van de AVG. Uiteraard wil je als gameontwikkelaar een toffe game ontwikkelen die voldoet aan de wensen van de klant. Maar sommige ontwerp-ideeën en wensen leveren het risico op dat je daarbij niet voldoet aan de AVG. Een deel van de ontwikkelaars lost dit op door deze ideeën niet toe te passen en niet in te gaan op deze wensen en doet hiermee concessies. Hoe fijn zou het zijn wanneer je zeker weet of een idee of een wens wel kan of met een kleine aanpassing toch binnen de AVG valt?

Om die reden is de GDPR Pitstop ontwikkeld. De GDPR is er om ontwikkelaars in het ontwikkelproces te ondersteunen en heeft als doel gameontwikkelaars te sterken in datageletterdheid en juridisch bewustzijn over de AVG-wetgeving en deze toegankelijk te maken.

Zo volg je alles over de AVG-tool

De GDPR Pitstop stelt ontwikkelaars in staat om zelf tijdens de ontwikkeling van de game een quickscan en een deepscan uit te voeren, met als resultaat aanbevelingen in begrijpelijke taal. Dit kost je als game developer niet veel tijd en dit levert waardevolle informatie op. Je weet aan het eind van de test op welke onderdelen de game voldoet aan de AVG en welke aandachtspunten er zijn. Dit geeft de gameontwikkelaar een belangrijk houvast tijdens het ontwerpen van de game.

De GDPR-tool is gratis en is hier te vinden. Op dit moment zijn we bezig om de tool te vertalen in het Engels. Aanvullend kun je op onze Lectoraat-pagina meer lezen over onze onderzoeken. De komende maanden besteden we regelmatig aandacht aan de GDPR Pitstop, dus als je nieuwsgierig bent kun je ons ook volgen op LinkedIn. Op 6 oktober 2022 zijn we tevens te vinden op de Dutch Media Week, waar je onze stand kunt bezoeken.

Missie 6: De gebruiker aan het stuur

Dialoog tussen mens en algoritme.

Dingen die ik doe beginnen vaak vanuit een verwondering: “Goh, hoe maak je nou een eetbare hot sauce met de ‘Carolina Reaper’, de heetste peper van de wereld?”, “Goh, hoe kan AI ingezet worden om te ondersteunen in het schrijven van een Dungeon and Dragons verhaal?”. Ook deze missie kwam vanuit een verwondering. Die ontstond toen ik aan onze lector Koen van Turnhout vertelde dat, wanneer ik thuis in het weekend een Mexicaans diner heb met vrienden, graag mariachi muziek draai. Supergezellig voor dat moment, maar een stuk minder voor de maandagochtend daarop aan het ontbijt zit en Spotify mariachi muziek aanbeveelt. Uiteraard kan ik ervoor kiezen om niet mijn profiel te gebruiken of anoniem te blijven. Maar dat kan niet de bedoeling zijn van media technologie die met de dag slimmer moet worden. “Goh, wie bestuurt wie nou?

In deze missie zal ik me dus storten op de vraag: hoe zorgen we ervoor dat algoritmes beter rekening kunnen houden met de wensen van een gebruiker op een bepaald moment?”. Vanuit de data science hoek is het antwoord dan simpel: betere algoritmes. Dus meer data, slimmere algoritmes met als resultaat betere voorspellingen. Als iemand met een informatica achtgrond zie ik dat er inderdaad verbeteringen kunnen doorgevoerd worden. Niet alleen in de werking van het algoritme maar ook in de controle over het algoritme. Is het niet mogelijk te maken dat ik als gebruiker de werking van het algoritme kan beïnvloeden? Wat mij betreft wel. Waarom kan ik niet ervoor kiezen dat het algoritme mij vergelijkt met de stad waarin ik woon? Waarom kan ik mijn data dubbelganger niet vinden? Waarom kan ik mijn aanbevelingen niet omdraaien naar bijvoorbeeld ‘de slechtste eerst’? Waarom kan ik de parameters van het algoritme niet direct beïnvloeden? Ik wil een gebruikersinterface waar ik die parameters kan sturen om zo tot een goed resultaat te komen.

Maar is het dan zo s impel als extra knopjes toevoegen? Nee, ik denk dat het complexer is dan dat. Want laten we het volgende eens overwegen: wat als algoritmen de rol overstijgt van slechts code die onvermoeibaar op de achtergrond werkt en een prominente functie wordt van een dienst. Als we dit doen is het niet meer een paar regels code maar een artefact, eentje die we vorm moeten geven. Dit brengt ons op het terrein van human-computer interaction waar artefacten/objecten/dingen bepaalde actiemogelijkheden hebben: zogenoemde affordances. Affordances omvatten de mogelijkheden en richtlijnen over wat een bepaald object wel en niet zou moeten doen. Vaak zijn de affordances van een object waarneembaar. We kunnen dan door naar het object te kijken zien welke actiemogelijkheden beschikbaar en gewenst zijn. Bij een deurklink kun je bijvoorbeeld aan het voorwerp en de context zien wat je ermee kan doen: openen. Deze voor de hand liggende eigenschappen zorgen ervoor dat gebruikers het aanbod op een beoogde manier gebruiken. Actiemogelijkheden kunnen ook niet zichtbaar zijn maar verborgen. In gebruikersinterfaces zonder duidelijke voordelen, moeten gebruikers vaak vertrouwen op ervaring en/of vallen en opstaan om mogelijke acties te bepalen. Wij zien algoritmen als artefacten met verborgen functionaliteiten.

impel als extra knopjes toevoegen? Nee, ik denk dat het complexer is dan dat. Want laten we het volgende eens overwegen: wat als algoritmen de rol overstijgt van slechts code die onvermoeibaar op de achtergrond werkt en een prominente functie wordt van een dienst. Als we dit doen is het niet meer een paar regels code maar een artefact, eentje die we vorm moeten geven. Dit brengt ons op het terrein van human-computer interaction waar artefacten/objecten/dingen bepaalde actiemogelijkheden hebben: zogenoemde affordances. Affordances omvatten de mogelijkheden en richtlijnen over wat een bepaald object wel en niet zou moeten doen. Vaak zijn de affordances van een object waarneembaar. We kunnen dan door naar het object te kijken zien welke actiemogelijkheden beschikbaar en gewenst zijn. Bij een deurklink kun je bijvoorbeeld aan het voorwerp en de context zien wat je ermee kan doen: openen. Deze voor de hand liggende eigenschappen zorgen ervoor dat gebruikers het aanbod op een beoogde manier gebruiken. Actiemogelijkheden kunnen ook niet zichtbaar zijn maar verborgen. In gebruikersinterfaces zonder duidelijke voordelen, moeten gebruikers vaak vertrouwen op ervaring en/of vallen en opstaan om mogelijke acties te bepalen. Wij zien algoritmen als artefacten met verborgen functionaliteiten.

Dit brengt mij op de kern van mijn missie: Algorithmic Affordances. Het zichtbaar maken van verborgen actiemogelijkheden die een algoritme heeft en daarvoor te ontwerpen. Het komende jaar ga ik ontdekken hoe ik theorie en praktijken vanuit human-computer interaction, user experience design, en data science kan combineren om gebruikers meer controle te geven over algoritmen. Ik ga op zoek naar voorbeelden uit de praktijk die meer controle geven en waar ze een meerwaarde kunnen bieden. Ook zal ik werken aan prototypes waar gebruikers meer controle over algoritmes hebben. Ik zal mij niet beperken tot alleen aanbevelingssystemen maar ook algoritmes die complexe tekstanalyses doen meenemen. Dit zal uiteindelijk leidden tot een pattern library die professionals uit het veld kunnen gebruiken. Daarnaast heb ik ook wetenschappelijke vragen: wat is de impact van Algorithmic Affordances op de tevredenheid, het vertrouwen, transparantie, gevoel van controle, accuratesse en publieke waarden van algoritmen?

Er valt nog genoeg te ontdekken en ik nodig jullie dan ook graag uit om mee te doen met deze missie. Ben je een designer, data scientist, een student, innovatie manager, onderzoeker of gewoon nieuwsgierig? Neem contact op met mij via hemdmissies@hu.nl en “goh, laten we samen eens kijken wat we samen kunnen ontdekken”.

Bekijk hieronder het interview met Erik Hekman tijdens de openbare les van lector Koen van Turnhout. Hierin vertelt hij meer over zijn missie ‘De gebruiker aan het stuur’.

Photo by ThisisEngineering RAEng on Unsplash

Missie 5: Dear human, can I actually help you?

Up until a few years ago, I did not care much about Conversational Interfaces all that much. Chatbots I would avoid altogether. To me Siri was laughable. Its mistakes made me, and my friends laugh when it would fail to understand my accents and Alexa a finicky device no serious person would use for a real task. I am not sure where this attitude was coming from, but it had a lot to do with my bad experience with virtual assistants who could never help with anything, yet always asked “is there anything else I can help you with today?”

Today, I must admit, advances in speech and language technology are gaining ground fast. In particular machine’s understanding of natural languages is becoming increasingly reliable, and many companies are planning to utilize speech and language interfaces. So, as using voice is going to radically change the way we do things, speech and language interfaces need a closer look now; will they change the way we interact with machines, and what does this mean for the user?

First things first, let’s get to the basics; what is a Conversational Interface? Well, the term is self-explanatory and includes any communication with machines in which we use natural language, like in a real conversation. The interaction can be through text (e.g. chatbots) or speech (e.g., voice assistants) but the underlying technology is the same. The fact that they are easy to use and can serve as a 24/7 virtual assistant has made them popular across the globe for a wide range of services. From simple Q&A type of conversation to flight reservation and online shopping assistance to news aggregation they are being used by an increasing rate. However, there is a catch; users expect to be served as effectively and reliably as they were with the human-based systems before, and they are unforgiving once the system fails to understand them, keep them engaged or show human like empathy. So, a truly satisfactory user experience is something yet to be delivered by industry, but more importantly, there is the question of putting this technology to the most impactful use.

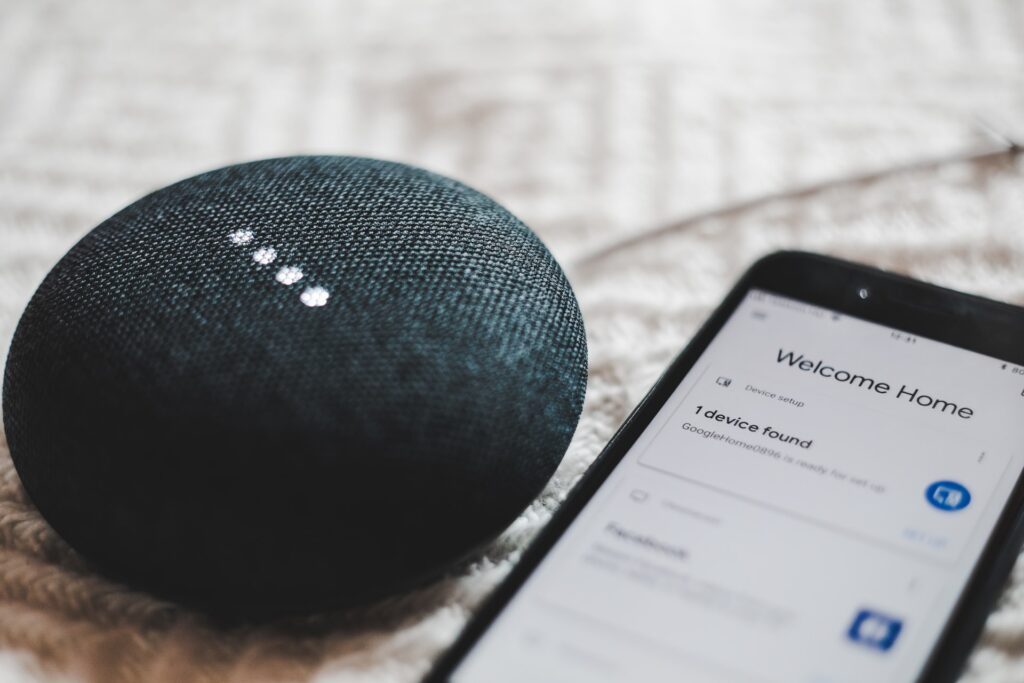

Much like it is with any other cutting-edge technology, it would take a lot of effort before Conversational Interfaces find the right purposes. Oftentimes, those fields that can make quick money, by selling pure novelty, even in less meaningful ways, are the ones that introduce technology to the public. The same has happened here for the likes of Alexa and Google Home. They have both developed into very popular voice assistants which can answer short questions, read the news for you, set reminders, and check your calendar and email. They can also control your home devices, when you ask them “increase the temperature” or “turn off the light” and even do a series of actions as customizable routines all with one command. Now Alexa apparently has a real advantage over Google Home when it comes to online shopping and it does its best to help you shop from Amazon. But it is only Google that can understand Dutch, so there you go if you were still undecided between the two.

Much like it is with any other cutting-edge technology, it would take a lot of effort before Conversational Interfaces find the right purposes. Oftentimes, those fields that can make quick money, by selling pure novelty, even in less meaningful ways, are the ones that introduce technology to the public. The same has happened here for the likes of Alexa and Google Home. They have both developed into very popular voice assistants which can answer short questions, read the news for you, set reminders, and check your calendar and email. They can also control your home devices, when you ask them “increase the temperature” or “turn off the light” and even do a series of actions as customizable routines all with one command. Now Alexa apparently has a real advantage over Google Home when it comes to online shopping and it does its best to help you shop from Amazon. But it is only Google that can understand Dutch, so there you go if you were still undecided between the two.

Market research shows the number of voice assistants owned by US households grew exponentially and reached 25 million by 2020. A survey from 2018, only 5 months after Google Home added Dutch to its list of supported languages showed that 5% of Dutch household had already owned the device. These numbers are remarkable since these devices do not seem to have a unique selling point, especially since most of the applications were already available in another mode of interaction, some even with voice assistants of the mobile phones. So, the fact that such advanced technology is put in use for such a trivial service is underwhelming for me. To be honest we have been doing perfectly fine before, especially without all the eavesdropping and spying concerns. While this is not the first time, we are using high tech to make our life slightly more efficient and enjoy something cool or convenient, but it is perhaps one of the most suitable technologies for a more purposeful use. So, I keep wondering isn’t it possible- to harness this technology in more impactful, more inclusive, more meaningful ways, beyond, or at least besides using it for arranging our appointments and playing our favorite playlist?

Seeking something “good,” and “meaningful,” is what has taken me on a long journey in my career, from Computer Engineering to Artificial Intelligence and Cognitive Science and Social Innovation, and now Human Experience. All along I have been in search of the human side of things, and particularly, looking for ways to improve the life of the disempowered and marginalized and excluded. And for this mission, as part of my research within the framework of “AI for Social Good,” I want to investigate ways that speech and language technology can be used towards solving societal problems. In the coming year I want to look further into such opportunities and investigate if and how existing voice technology can help where there is no other service or solution.

A huge advantage of conversational interfaces for solving societal problems, over other technologies, is how they provide easy and cheap access to centralized information, which makes them both scalable and affordable. Also being available 24/7 and automatically responding to enquiries makes them even more effective and empowering. Take a crisis for example where fast widespread reaction is essential and think about ways a Chatbot can help. Imagine how a specialized voice assistant can help people in a remote place, by providing information on basic hygiene, proper use of certain medicine or food supplements they might have received from aid agencies. Try to picture how a refugee running from a war-torn country can use a voice assistant to reach safety, or how a well-trained Chatbot, can give one-on-one tutoring to millions of children that are out of school in refugee camps with no prospect of getting out anytime soon.

Domains that have potential for using Conversational Interfaces as an innovative solution are countless, both locally and internationally. From inclusion and social relatedness to health and wellbeing and from education to community engagement, to citizen journalism and activism and public legal assistance, there are plenty of opportunities to make a novel use of the technology, and there are in fact a few successful existing solutions too. Now that we have both the right purpose and the right means, it is time to ask both Alexa and Echo:

“Hey guys, which one of you knows how to do it?”

Interesting first post from Shakila Shayan, receive an update email when she’s posting her next by emailing hemdmissies@hu.nl or scroll down to the bottom to add your email to our mailing list.

Photo by BENCE BOROS on UnsplashMissie 4: Word ‘ik’ steeds meer een bot?

Bij het horen van bots gaat mijn geheugen graven in het verre verleden. Welke associatie heb ik met bots, wat toch een afkorting is van robots? Ik moet gelijk denken aan series en films waarin ik deze als eerste ben tegen gekomen. Mijn herinnering gaat terug naar Robocop, Terminator, Wall-E, Star Wars en Star Trek, dus films en series die al gebruik maken van robots.

Mijn eerste associatie met robots is blijkbaar gevoed door fantasierijke en toekomstgerichte films en series. Het zijn robots die menselijk gedrag vertonen in vorm, geluid en/of handelen. Veelal worden ze met een metaalachtige binnen– of buitenkant weergegeven en heb ik daarbij ook niet echt het gevoel dat ze knuffelbaar zijn. Aan de andere kant zijn er ook concepten van sprekende en denkende computers terug te vinden. Een van de eerste voice computers komt uit Star trek en komt daarmee in de buurt van een robot zonder fysieke presentatie.

“..bots of systemen die mijn werk uit handen nemen door dingen voor mij op te pakken”

Nu waren dat voorbeelden uit een fantasiewereld en niet de wereld waar ik nu in leef. Robots of bots kom ik in het dagelijks leven regelmatig tegen, denk ik. Ik denk het, omdat ze niet altijd zichtbaar zijn, maar wel aanwezig. De waarneming begint bij chatbots op verschillende websites en in apps. Daarin kan ik vragen stellen waarna ik soms direct geholpen ben. Automatische mails van Marktplaats over producten die ik misschien interessant vind. Mijn Fitbit smartwatch die zegt dat ik moet gaan lopen, of dat ik het goed gedaan heb. In Slack (een soort community/productiviteitstool) zit een bot met de naam ‘Slackbot’ om mij op weg te helpen in het programma Slack. We zien menselijke communicatie door een onmenselijk ding. (Impersonatie)

Verder heb ik ook gedachtes over fysieke bots die voor mij pakketjes in een hal ophalen of mijn auto in een fabriek in elkaar lassen. Daarnaast ben ik regelmatig geholpen door voice bots bij callcenters van verschillende maatschappijen. Indien contact dan moet ik eerst mijn postcode opgeven om daarna de meest gestelde vragen vanuit mijn regio te krijgen of verteld te worden dat er geen storingen zijn, waarna abrupt de lijn verbroken werd. En misschien vallen hier ook Siri, Google Assistants en Alexa onder. De laatste bots die ik tegenkwam, komen veelvuldig in het nieuws. Het zijn de twitterbots, die automatisch berichten liken of doorsturen en daarmee een effect op Twitter proberen te bereiken. Het landschap van bots dat ik al kan benoemen, en niet zeker weet of het wel bots zijn, hebben veel verschillen en lopen enorm uiteen. Ik ben vooral benieuwd naar de invloed van deze bots in ons dagelijks leven. We gaan het onderzoeken.

Beinvloeden bots direct mijn ervaring van leven?

Het lijkt erop dat ik in redelijk wat situaties in contact kom met bots of systemen die mijn werk uit handen nemen door dingen voor mij op te pakken. Ze lijken mij te helpen, te sturen, te controleren of te informeren. Soms doen ze dit zelfs uit eigen beweging. Zetten ze de verwarming vast aan, beantwoorden ze een vraag, geven een notificatie als ik zelf niet oplet of vragen ze hoe mijn dag was. Ze nemen daarmee een stuk je verantwoordelijkheid en keuzevrijheid van mij over. En terwijl ik dit opschrijf word ik er best vrolijk van en spreek ik ze aan met “ze”. Een persoonsvorm, alsof het iets is wat leeft. Dat vrolijk worden staat hier overigens apart van. Ik denk dat dit vooral komt door het opschrijven van de dingen die ze allemaal voor mij doen. Gaaf toch, wat is er mis mee? Ze doen duidelijk iets goeds, toch? Mijn ervaring verbeteren? Mijn gevoel beïnvloeden. Wacht even, mijn gevoel beïnvloeden? Nu wordt het persoonlijk en wil ik weten of bepaalde bots mij zo proberen te beïnvloeden dat ik mij anders ga gedragen en mij dus sturen in een richting die normaal gesproken helemaal niet voor mij geweest zou zijn.

“Ze doen duidelijk iets goeds, toch?”

Ervaar jij dit ook? Dat bots een goede toevoeging zijn op het leven, omdat het leven hierdoor makkelijk en beter wordt? Of juist niet en hangt er een negatieve gedachte rond bots die invloed hebben op keuzes en gedachten? Wat doen bots nu voor jou op dit moment? En wat zouden ze nog meer mogen doen van jou? Je bankzaken? Je likes geven aan vrienden? Een betere verzekering afsluiten aan de hand van je leeftijd, gedrag en andere kennis die de bot heeft? We gaan op zoek naar antwoorden op dit soort vragen. Bij experts die de bots bouwen, maar vooral bij mensen die ervaring hebben met bots. Eens kijken hoe bewust we ons zijn van bots en de taken die we langzaam weggeven aan deze technologie.

De volgende stappen

Deze eerste blog over de missie bots is een introductie op de verkenning die ik (Marcel Stalenhoef) zal gaan doen op het gebied van Human Experience & Media Design. Simpel gezegd, ik verken het fenomeen ‘bots’ met focus op de ervaring, emotie, gedachten en wensen van mensen.

“Blijven we in controle of geven we het (te makkelijk) weg?”

In de eerste verkenning is naar voren gekomen hoe mijn persoonlijke ervaring met bots en het opgroeien met computers, software en internet technologie niet negatief is geweest. Het is zelfs onderdeel van het vakgebied waar ik nu als onderzoeker/designer aan het werk bij de Hogeschool Utrecht en het Lectoraat HE&MD. Maar we staan ook op een nieuw punt in deze technologische groei en integratie met ons leven. Het lijkt daarin minder transparant te worden, terwijl er ook steeds meer gedaan wordt door deze bots technologie.

Ik wil daarom voor jullie onderzoeken of deze integratie van bots in ons leven en de verschuiving van taken, beslissingen en daarbij komende verantwoordelijkheid naar bots gewenst is. Blijven we in controle of geven we het (te makkelijk) weg?

In de volgende publicatie wil ik de kennis over, de ervaring met en het gevoel bij bots peilen door middel van interviews met een diverse groep Nederlanders uit de verschillende generaties. Mocht de tijd hierin voorzien dan is hun gedachten over de toekomst met bots en het weggeven of juist vasthouden van hun verantwoordelijkheid (agency) ook een onderdeel, anders komt dit terug in de derde publicatie.

In het loop van het traject zou ik willen kijken naar een visualisatie van het onderzoek. Uit het onderzoeksteam kwam al een suggestie van een kwadrant met bijvoorbeeld de assen “de maat van autonomie”, “de maat van verantwoordelijkheid” met natuurlijk de mens en bots als uitgangspunt. Maar we zouden hierin ook kunnen kijken naar de prioriteitenmatrix van Eisenhower of de Three Laws of Robotics van Asimov.

Geef hieronder alvast je mening of reactie over deze missie. Vind je het interessant en blijf je onze missie volgen? Of wil een keer helpen? Mail ons met je naam en email naar hemdmissies@hu.nl met het onderwerp “BOTS MISSIE”.

Bekijk hieronder de video’s , waarin Marcel meer over zijn missie vertelt:

De producties voor deze missie worden ondersteund door redacteur Natascha van der Vegt

Bekijk hieronder eerdere items van deze missie:

Missie 3: Grover in 3D. Is dat een goed idee?

“Hello! It is me, your lovable friend Grover. Come over here towards me, come closer.” Via Virtual Reality (VR) brillen zien kleuters het blauwe pluizige karakter uit Sesamstraat vrolijk naar hen zwaaien. Afgesloten van de werkelijke wereld komt VR-Grover een stuk groter en realistischer over dan zijn TV-versie. Ook kan VR-Grover tot het puntje van je neus komen en daarmee de veilige afstand overbruggen. Ik vraag mij af of deze monsterlijke versie angsten bij de kleuters oproept of dat ze deze meer tastbare versie eerder omarmen als vriend. De resultaten zijn gemixt: krap de helft van de kleuters is niet bereid om naar VR-Grover toe te lopen. En toch doet de meerderheid VR-Grover na in een spelletje Simon Says en is zelfs bereid stickers met hem te delen.

Het zijn resultaten uit een zeldzame studie naar de effecten van VR-producties op kinderen. Zeldzaam, omdat kinderen tot dusver weinig aandacht krijgen in VR-onderzoek. VR valt onder de zogenoemde “immersieve” technologieën die virtuele omgevingen kunnen creëren die levensecht aanvoelen en waarin je helemaal opgaat. Dit stelt kinderen in staat om te spelen en te leren op manieren die anders onmogelijk, te gevaarlijk of te duur zouden zijn. Denk aan het besturen van vliegtuigen, het onderzoeken van de diepten van de oceaan, het uitvoeren van risicovolle scheikundige proefjes, het ontmoeten van mensen uit andere culturen in verschillende tijdsperiodes, reizen door het menselijke lichaam, en zelfs spelen met verschillende identiteiten. Ook in de zorg wordt VR vaker ingezet, bijvoorbeeld om sociale vaardigheden te oefenen, angsten en operatiestress te verminderen, en om kinderen de mogelijkheid te bieden om met anderen virtueel buiten te spelen.

VR wordt steeds goedkoper en toegankelijker. De verwachting is dat steeds meer kinderen in aanraking zullen komen met VR, maar eigenlijk weten we nog weinig van hoe kinderen VR beleven. Kinderen verwerken mediatechnologie en -inhoud anders dan oudere leeftijdsgroepen. Ze vinden het bijvoorbeeld lastig om fictie van realiteit te onderscheiden. Als jonge kinderen VR als realistischer ervaren dan volwassenen, worden ze er waarschijnlijk ook meer door beïnvloed: van invloedrijkere rolmodellen en leeromgevingen tot misschien wel nachtmerries, ongewenste leereffecten en zelfs valse herinneringen. Als early adopters van mediatechnologieën zijn de meeste kinderen erg geïnteresseerd in VR, maar zijn hun ouders enigszins bezorgd over de lichamelijke en psychische impact. Misschien zou er een kijkwijzer moeten komen voor immersieve technologie als VR.

De fascinatie voor (media)producten als VR voor kinderen had ik al voordat ik onderzoeker werd. Kinderen zijn mijn favoriete doelgroep: spontaan, bruut eerlijk, bomvol fantasie en soms nog onverwacht kwetsbaar en lief. Tel daarbij op dat ze om de zoveel jaar veranderen en groeien door mentale en sociale ontwikkelingen en je kunt concluderen dat deze doelgroep nooit saai is. Immers, wat werkt voor een 4-jarige, werkt niet meer bij een 7-jarige en al helemaal niet bij een 12-jarige. Ik wil graag weten hoe we media effectief kunnen inzetten om kinderen gelukkiger, gezonder, zelfverzekerder en slimmer te maken. Binnen het lectoraat HEMD probeer ik daarom de mediavoorkeuren en -kwetsbaarheden van verschillende leeftijdsgroepen inzichtelijk te maken en toe te passen. Mijn droom is om uiteindelijk “meegroeiende” media-inhoud te ontwikkelen. Denk bijvoorbeeld aan het karakter Grover dat naarmate je ouder wordt automatisch zijn uiterlijk, spraak en gedrag aanpast aan jouw voorkeuren. Op die wijze kan Grover een duurzaam rolmodel worden. Het is ook geen toeval dat mijn missie een karakter aanhaalt, want binnen het lectoraat heb ik een onderzoekslijn die zich helemaal richt op hoe we interacteren en relaties opbouwen met niet-menselijke actoren – zoals een fictief karakter, robot of chatbot – en hoe dit onze ideeën en gedrag kan beïnvloeden.

Vanuit deze achtergrond neem ik de uitnodiging van VR-Grover aan om dichter naar hem toe te komen. Niet om Simon Says met hem te spelen, maar om zijn wereld te verkennen door de ogen van kinderen van verschillende leeftijden. Ik nodig je uit om mee te gaan op mijn zoektocht en antwoord te vinden op de vraag wanneer interacties met VR-karakters voor kinderen een goed idee is. Hiervoor moet ik onder andere achterhalen hoe VR-karakters verschillen van karakters in andere mediavormen, hoe kinderen interacteren en potentieel relaties vormen met VR-karakters, wat de voor- en nadelen zijn van VR-karakters voor verschillende leeftijdsgroepen, en in welke situaties interacties met VR-karakters tot gewenste effecten leidt. Concreet moet de zoektocht leiden tot een aantal voorwaarden waaraan VR-karakters voor kinderen moeten voldoen.

Natuurlijk ben ik ook benieuwd naar jouw eigen vragen, meningen en toekomstideeën over VR- karakters voor kinderen. Dus stuur mij jouw mooie en minder goede voorbeelden van VR-producties, laat me weten wat kinderen in jouw eigen omgeving van VR- karakters vinden of stuur me tips over artikelen of experts die een bijdrage willen leveren.

Een bijdrage leveren? Mail mij via hemdmissies@hu.nl

De producties voor deze missie worden ondersteund door redacteur Maxim Hardebol

Bekijk hieronder eerdere items van deze missie:

VR: ervaring en beleving, een terugblik

De werking van karakters in VR

Digitaal kinderen leren laten spelen

Missie 2: Data Bias as an Emerging Challenge in the Digital Society

How to Build Inclusive Digital Technology?

Imagine trying to unlock your phone with your fingerprint, but it just won’t scan it because your thumb is too small. Or you keep repeating the same phrase over and over again, but your mobile phone’s voice assistant still doesn’t “understand” what you’re trying to say.

Some of us are familiar with these kinds of glitches that lower our user experience. Mostly, we do not think much of it. We either adjust or simply replace the product. However, sometimes these annoying things happen not because the technology is necessarily “broken” or is “designed poorly”. Quite to the contrary, it might very well be the case that a device or digital service was designed that way. The problem is then that you are the “error”, that you simply do not match the “regular user” the creators had in mind. The device in front of you acts differently towards you than towards the general public.

In this case you may experience a (mild) form of data bias: data-driven systems that are not accessible for everybody and exclude or even discriminate against users who do not fit the “standard”. In the above examples, the stakes are relatively small. Still, the same problem can negatively impact people in other contexts. There are plenty of examples: voice recognition systems that cannot “understand” minority accentsfacial recognition solutions that are blind for people of colour, algorithms that are biased against women, or digital designs that are insensitive for the needs of elderly people. Data bias occurs in various sectors and situations. It either excludes certain types of people –or categorises them in an unfavourable way. For example, when people with a migration background are considered as less trustworthy when it comes to paying taxes or credit worthiness.

(Photo by ryoji-iwata)

As a researcher, I am interested in the impact of data and technology on people in a social and cultural respect, i.e., how they shape our relationships and how we look at each other. I think that data bias is an urgent (and fascinating) problem that professionals, regulators, and the public should pay attention to.

I have always been interested in how society defines its “standards” and how the systems we build react to “misfits”. This is to some extent influenced by my very personal experience: growing up in a mixed raced family (Asian father, European mother) in Germany of the 1990s, frequently put me in situations where I simply did not fit in. Over the years, I built some sensitivity for categorisations, stereotypes, deceptive assumptions, and thus biases throughout my life. It inevitably steers my views, approaches, and professional interests. And we see more situations emerging in which these challenges become concrete -with digital technology taking centre stage in the relationships that we build.

If you talk in your native accent and your voice assistant does not understand you, you have two choices: change the way you speak or stop using the technology. If a facial recognition app cannot “read your face”, it is simply useless for you. These issues feel annoying, and a user becomes a non-user very quickly. However, in the worst cases biased digital technology can appear explicitly racist (as happened with Google’s image recognition algorithm), sexist (for example, Amazons data-driven recruitment tool), ableist (e.g. when data-driven tech is not accessible for disabled people), or ageist (also in e.g. recruitment and usability of tech). These are real and hurtful experiences for the individuals at the receiving end.

Data bias also affects user experience. Designers of user-centric, data-driven technologies are not always aware of the negative impacts that they have on people;, or they downplay and ignore them. The stakes are high, however: a company may cause real harm to people, which is by itself already bad enough. But there are also costs in reputation, loss of public support, and even potential legal penalties to consider. None of that is desirable for designers. Understanding data bias, its complexity and variety, and how to develop counterstrategies can help with avoiding damage for all sides involved.

Problems of data bias emerge when creators of technology put a little too much trust into their assumptions about who represents most users and fail to consider people that may sit outside of that mainstream. Or even worse, actively decide to exclude them. Data biases result from conscious or unconscious choices among creators of technology. However, economic imbalances and access to technology are additional factors to consider. For example, in some regions, communities have sensors to collect data about e.g. air quality; if the quality drops, they can intervene. Other communities do not have the means to monitor their environment and have thus no chance to protect their environment as efficiently.

Data bias can affect the individual user (or customer or citizen) but also larger parts of society. It can be a result of ignorance, naivety, or plain malevolence. Some forms of data bias are caused by personal choices of tech creators, while many are the outcome of complex systemic issues in how society at large deals with inclusion and exclusion. More often than not, hard business goals play an important role, too.

Understanding Data Bias

In my mission, I will explore different forms of data bias and their causes. For this, I will investigate and compare how different private and public organisations deal with the issue. This is a necessary first step before we can develop remedies. I will focus especially on user experiences (UX) of digital designs in different sectors. Guiding questions are:

- How do design choices (involuntarily) contribute to data bias?

- How do research practices such as “personas” in user experience design relate to bias?

- How do UX designers define “standards” when it comes to designing of user groups?

I am less concerned with finding technical, algorithmic solutions to the challenges of data bias (and discrimination). I rather want to focus on the social and cultural factors:

- How do designers make and justify their choices?

- How transparent and exhaustive is their preliminary research on target audiences?

- What sensibilities are missing –and when do either economic and/or political factors outweigh ethical considerations?

I try to achieve this by talking to designers, organisations. users, and through critically analysing processes that can lead to biases. I am supported in this effort by my colleague Levien Nordeman, who is a passionate educator and critical thinker with whom I share a keen interest in how data is changing society.

Finding Solutions

I am curious about the ways in which people look at and think about the digital transformation. I am equally interested in how technologies and the organisations behind them gaze at people as users. Through understanding the different sides, we can identify problems as well as misunderstandings and start looking for solutions.

Professionals in the field are neither ignorant nor insensitive towards the risks of digital technologies. More data-driven organizations and their designers explore how to practice ideas such as “privacy by design” and actively seek ways to increase transparency and discuss data ownership. This is a starting point to raise the position of users to the level of a partner in a dialogue about data: what they represent and what can be done with them. There is growing awareness that data are not just an objective “thing” but that is matters how people who collect them also make sense of them.

However, researchers and practitioners also need to explore what strategies help with avoiding biases and how to include a broad spectrum of different people. We want digital technology to be able to distinguish between us; we want them to recognize who we are and offer the same service quality for everybody. What we don’t want are racist, sexist, ableist, ageist and overall exclusionary designs. We don’t want “blind” algorithmic solutions that run user-centric devices. But it all starts even before the first line of the algorithm is written: at the conceptualisation and ideation stages of any project. We need to understand and challenge the underlying assumptions of individual practitioners and their organisational cultures.

As users, we rely on designers who critically reflect on data bias and ideally embrace ideals of inclusion by design. This mission tries to make a humble contribution to support them in this effort.

De producties voor deze missie worden ondersteund door redacteur Aaron Golub

Here you will find all the other items of this mission:

Missie 1: HELP, Spotify begrijpt me niet!

Het is donderdagavond. De laatste aflevering van het laatste seizoen van een fijne serie op Netflix is afgelopen. Het is niet laat, en zeker niet zo laat dat je al naar bed wilt, maar niet zo vroeg dat je nog overweegt de deur uit te gaan. Wat nu?

(Pak een boek, hoor ik mijn moeder roepen).

Het einde van de serie is goed. Daar zijn jullie het over eens. Echt goed. Als dit echt het laatste seizoen was dan is dat verhaal goed verteld. Maar eerlijk gezegd ben je nog niet klaar om afscheid te nemen van deze serie. Hij was weliswaar al een paar jaar oud, maar jij ontdekte hem pas vorige maand en in één maand heb je alle seizoenen er doorheen gejast. Wat vroeger een liefdesrelatie van een paar jaar was, tussen jou en Grey’s anatomy, of tussen jou en Prison Break, is nu een hele heftige korte relatie: bloedspannend, zo weer over, en daar zit je op de bank met je lege gevoel. Je zoekt op internet nog of er een volgend seizoen komt, want je bent nog niet klaar om afscheid te nemen. Dat komt er, waarschijnlijk, of misschien niet, maar als het komt, dan pas volgend jaar september, de opnames zijn nog niet gestart. Potentieel fijn nieuws, maar wat doe je ondertussen?

(Mam, echt! Ik hoorde je net ook wel)

En dan doet Netflix een suggestie: “Aletta, omdat je “The Good Place” hebt gekeken, raden we nu deze series aan”. Je scrolt door het rijtje aanbevelingen, en bij verreweg de meeste daarvan denk je “Hoezo!?” Hoezo dacht Netflix dat dit een goede suggestie was? Op basis van welke eigenschappen van een serie beslist Netflix: joh, dan is dit een goede optie? Op basis van welke eigenschappen van mij als kijker, dacht Netflix: maar dan vind je vast ook dit leuk. Het lijkt er niet eens op!

Waarom begrijpt Netflix mij zo slecht? Of Spotify, met zijn Discover Weekly. Waarom zit daar zo vaak rommel tussen? Of Bol.com met zijn “andere kopers kochten ook dit” en die dan boeken aanraden die ik al lang een keer gekocht had of die ik echt nooit ga lezen. Of een datasite met tamelijk obscure suggesties. Op basis waarvan doen dit soort diensten hun aanbevelingen? En waarom zitten die er zo vaak naast?

Dit soort diensten genereren hun aanbevelingen met behulp van zogenaamde recommender systemen. Dat zijn algoritmes die (1) op basis van eigenschappen die verschillende producten gemeenschappelijk hebben of (2) op basis van wat verschillende gebruikers onderling gemeenschappelijk hebben, een match proberen te vinden. De openbare missie “Spotify begrijpt mij niet” onderzoekt hoe deze recommender systemen werken. Wat gebeurt onder de motorkap van zo een aanbevelingssysteem? Waarom klopt de aanbeveling soms? Waarom klopt hij zo vaak helemaal niet? Hoeveel producten heb je eigenlijk nodig om een goede aanbeveling te maken? Waar kunnen we invloed op uitoefenen? En hoe werken de aanbevelingen samen met de businessmodellen van de diensten? Wij onderzoeken in deze missie waarom Spotify ons niet begrijpt en waarom Netflix ons niet hoort. We onderzoeken trouwens niet hoe Google en Facebook zoekresultaten, berichten en advertenties voor ons selecteren. Dat is ook een spannend onderzoek, maar daar komen nog weer hele andere dingen bij kijken. Wij houden het even bij de Spotifies van deze wereld. En de Bol.commen. Dating sites natuurlijk. En Netflix dus.

Stel, bijvoorbeeld, dat je “The Good Place” hebt gekeken en dat vond je een fijne serie (echt! Ga de Good Place kijken als je dat nog niet gedaan hebt”). Ik heb nog expliciet aan Netflix laten weten dat ik het een fijne serie vond door een duimpje omhoog te zetten bij mijn review.

Netflix kan dan op zoek naar andere series die kenmerken gemeenschappelijk hebben met The Good Place. Bijvoorbeeld: deze andere serie is ook een comedy. Bijvoorbeeld: deze andere serie heeft dezelfde acteurs. Of dezelfde producer. Of dezelfde decorbouwer (dat gebeurt ook). Dat heet een “content-based” recommender system.

Netflix kan ook op zoek naar andere gebruikers die “The Good Place” een duimpje omhoog gaven. En dan in hun lijstje kijken welke series die andere gebruikers goed vonden. Zo’n andere serie kunnen ze dan weer aan mij aanbevelen. Dan gaan ze er van uit dat als je alle twee “The Good Place” leuk vond, dat je ook alle twee die andere serie leuk vindt. Dat heet “user-based” recommender systemen.

Welke systeem je ook gebruikt: je hebt sowieso ontzettend veel users en ontzettend veel producten nodig (producties bij Netflix, boeken bij bol.com, muziek bij Spotify, elligible candidates op een matching site), om maar in de buurt te komen van een interessante aanbeveling. En je moet heel goed kiezen welke eigenschappen van een product of een user interessant genoeg zijn om mee te laten tellen.

Neem bijvoorbeeld als eigenschap van een serie: “de acteurs die erin spelen”. Zelfs als ik een van die acteurs echt goed vind, ben ik niet per se geïnteresseerd in een andere serie waarin een van die acteurs toen zij nog ‘young and upcoming’ was, één regel tekst had als de “tweede cafébezoeker van rechts” in de derde aflevering van seizoen 6. De eigenschap “de acteurs die erin spelen” is niet genoeg voor een goede aanbeveling. Of stel dat ik een avond een Mexicaans etentje heb gegeven en die hele avond voor de lol traditionele Mexicaanse mariachimuziek gedraaid heb, dan hoef ik de maandag erna in Spotify’s “Discover weekly” niet opeens allerlei obscure mariachibands te vinden. De eigenschap ‘welke muziek een user draait’ is ook niet altijd genoeg.

Maar wat is dan wel genoeg? Hoe moeten die eigenschappen gedefinieerd? Hoe vinden recommendersystemen de liefde van mijn leven voor mij op een dating site, waarmee ik dan perfect op ons aansluitende series op Netflix kan vinden, nadat we elkaar verleid hebben met echt goede muziek die Spotify voor ons gevonden heeft. Kopen we daarna (ja, mam!) een fijn boek dat Bol.com voor ons uitgezocht heeft.

Dus mijn vraag aan u is: wanneer heeft een recommender systeem u iets aanbevolen dat uw leven veranderde? Die muziek! Die documentaire! Dat boek! En wat zijn de raarste aanbevelingen die u gehad heeft? En trouwens ook: welke eigenschappen zijn voor u belangrijk in uw eigen aanbevelingssysteem in uw hoofd? U heeft een boek uit, u legt het weg, u gaat op zoek naar een nieuw boek: wat zijn dan dingen die u gebruikt om te zoeken? Terwijl u daarover na denkt en ons dat laat weten gaan wij ook alvast op zoek en proberen een interview los te peuteren bij het recommender team van Spotify.

De producties voor deze missie worden ondersteund door redacteur Remi Terhorst

Bekijk hier de andere items van deze missie:

Hoe Spotify jouw muzieksmaak bepaalt

De werking van algoritmes van dating apps

Berekeningen van aanbevelingssystemen