Inmiddels hebben we vastgesteld dat er veel onduidelijk is over de self-help apps. We weten in de regel niet wiens belangen bij de ontwikkeling zwaarder wegen en ook over de wetenschappelijke onderbouwing van de implementatie zijn vaak veel vragen. Het is logisch dat je daar naar kijkt en denkt: hier moet wat aan gebeuren, dit kan beter.

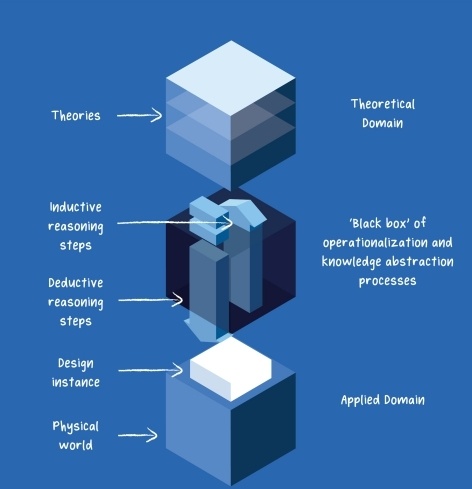

Het is zeker niet moeilijk om vervolgens een aantal ideeën te verzinnen om deze onduidelijkheid, de ‘black box’ waar we aan het begin van de missie over spraken, de wereld uit te helpen. Maar zulke ontwikkelingen gaan niet over één nacht ijs. Wanneer je verder nadenkt over wat nu een geschikte aanvliegroute zou zijn, ontdek je uiteindelijk dat het een veel complexer probleem is dan je in eerste instantie denkt.

Op welk vlak moet er bijvoorbeeld wat gedaan worden? Moeten er juridische kaders worden gecreëerd? Moet er op nationaal, of zelfs op EU niveau beleid worden geschreven? Moeten we wijzen naar de industrie zelf en hen vragen op een zelfsturende manier richting te geven aan de verantwoording? Of is het uiteindelijk de verantwoordelijkheid van de consument om zichzelf voldoende te informeren om de goede keuze te kunnen maken?

Bij het vorige item van deze missie spraken we Peter Oosterhoff van UTwente over de kloof in de verantwoording die moet worden afgelegd tussen app store-apps en software die wordt bestempeld als ‘medische tool’. Voor de tweede groep is er heel duidelijke regelgeving, terwijl voor die eerste groep, die misschien een vergelijkbare functie heeft, veel minder regels gelden. En het is ook niet zo dat de regels voor de tweede groep perfect zijn: voor software geldt bijvoorbeeld eigenlijk altijd de strengere set regels, terwijl deze software eigenlijk helemaal niet zo invasief is als andere medische tools die ook in die categorie vallen.

“Ik denk dat de oplossing voor het dichten van het gat niet is om meer regelgeving te creëren” zegt Peter dan ook. “Want die is er al. Ik denk wel dat er nu maar beperkt de mogelijkheid is om te zeggen dat iets een medische toepassing is, maar dat er tóch lichtere eisen voor zijn. Je zou dus kunnen kijken naar waar er juist ruimte is om dat los te laten, zodat het beter te doen is om apps daar wél in te laten passen.” De situatie nu heeft namelijk als gevolg dat alle ontwikkelaars die graag zouden zien dat hun app in een klinische context ingezet kan worden, veel geld kwijt zijn aan het verkrijgen van de benodigde certificaten. Zo veel, dat menig ontwikkelaar er voor voor kiest om een andere weg in te slaan.

Daar zit een groot gevaar: met het oog op innovatie en met name de toenemende wens voor Europese onafhankelijkheid van Amerikaanse bedrijven is het argument ook te maken dat we maar beperkt, of zelfs helemaal niet zouden moeten reguleren, om de kweekvijver te kunnen creëren waarin kan worden ontwikkeld. Beleid beweegt traag, en kan de ontwikkelingen binnen de wendbare tech-sector belemmeren.

Maar dit is al een vaak geopperd standpunt. Aan de andere kant staat natuurlijk de ervaring: de app-markt is inmiddels al meer dan tien jaar oud, en daar is nog onvoldoende eigen initiatief uitgekomen om de wildgroei aan banden te leggen en richting te geven aan de industrie die is ontstaan rond deze self-help apps. Moet de consument niet in bescherming worden genomen voor de bedrijven achter deze apps, om er zeker van te zijn dat deze het beste met de klant voor (moeten) hebben?

“Het is lastig om te voorkomen dat bedrijven toch iets op de markt brengen dat niet voldoet aan de gewenste normen. Dat zou misschien opgelost moeten worden door inspectie, aan de ene kant vanuit de app stores – al hebben zij daar zelf niet veel belang bij – en aan de andere kant zou je daar organisaties van therapeuten en andere professionals bij kunnen inroepen, die meer op een belonende manier kijken naar het onderwerp. Het hoeft natuurlijk niet negatief. Het kan ook gewoon een marketingpunt worden dat jouw app wél wetenschappelijk onderbouwd is.”

Daarbij komt ook nog de grote ‘elephant in the room’ op softwaregebied: generatieve AI. Je ziet tegenwoordig dat in de niet-medische toepassingen van gedragsinterventies en wellness-apps steeds meer AI wordt gebruikt. Dat kan heel nuttig zijn. Sommige mensen vinden het bijvoorbeeld veel prettiger om informatie te krijgen in een soort gespreksvorm, waar zij ook om verduidelijking kunnen vragen. “Maar we moeten wel echt voorzichtig zijn met de introductie van zaken als AI en machine learning in dit soort toepassingen. Als fabrikant moet je verantwoording nemen voor wat je op de markt zet, maar het probleem met generatieve AI is dat je eigenlijk nooit exact kan voorspellen hoe goed het is en wat het doet. Tenzij je grote studies zou gaan doen, maar als niemand jou dat verplicht, is de kans klein dat je dat daadwerkelijk ook doet.”

De vraag blijft dus wie überhaupt het vraagstuk over het verantwoord omgaan met self-help apps moet gaan beantwoorden. Peter is in ieder geval van mening dat het de markt is die het – vrijwillig – op zou moeten lossen. “Ze zouden moeten beseffen dat je niet met een stel jonge honden een app op niveau kunt ontwikkelen. Dat moeten ze laten uitvoeren door een bedrijf met ervaring in het ontwikkelen van klinische gedragsinterventies, of op zijn minst mensen uit die wereld nauw betrekken. En totdat dat besef er is, denk ik dat we het moeten gooien op particuliere initiatieven of consumentenorganisaties aan wiens normen bedrijven vrijwillig moeten willen voldoen. Ik denk niet dat meer regelgeving een goede oplossing is.“

Heb je iets van deze missie gemist? Hieronder zie je een lijst van alle posts rondom Missie 13: Rethinking Behaviour Change Technology!

- Missie 13: Rethinking Behaviour Change Technology

- Weet jij hoe jouw favoriete self-help app werkt?

- Datavisualisaties & fitness trackers: Geeft dat wel een eerlijk beeld?

- Waar gaat het mis in de ontwikkeling van self-help apps?

- Self-Help En ‘eHealth’, Wat Is Het Verschil?

Deze missie wordt ondersteund door redacteur Sander van Velze.