Een goed gesprek met Dr. Cynthia Bennett, postdoctoraal onderzoeker bij het Human-Computer-Interaction Instituut aan de Carnegie Mellon Universiteit

Datagestuurde technologieën worden vaak geprezen als efficiënte oplossingen die de kwaliteit van leven van verschillende mensen kunnen verbeteren. Dat is dan ook het grote doel van technologie: het mogelijk maken, versterken, vrijmaken en het creëren van “waarde”. Op het eerste gezicht lijkt een grote diversiteit aan mensen inderdaad te profiteren van technologische vooruitgang op het gebied van dataficatie, automatisering en robotica. Dat geldt ook voor demografische minderheden. Er is bijvoorbeeld een groeiend aantal “ondersteunende technologieën” die verschillende handicaps aanpakken, zoals protheses of ‘smart wearables’ voor mensen die te maken hebben met gehoorproblemen. Smart wearables zijn draagbare toepassingen die op of om het lijf gedragen worden en continue data versturen en ontvangen. Nieuwe technische innovaties van vergelijkbare aard duiken bijna dagelijks op.

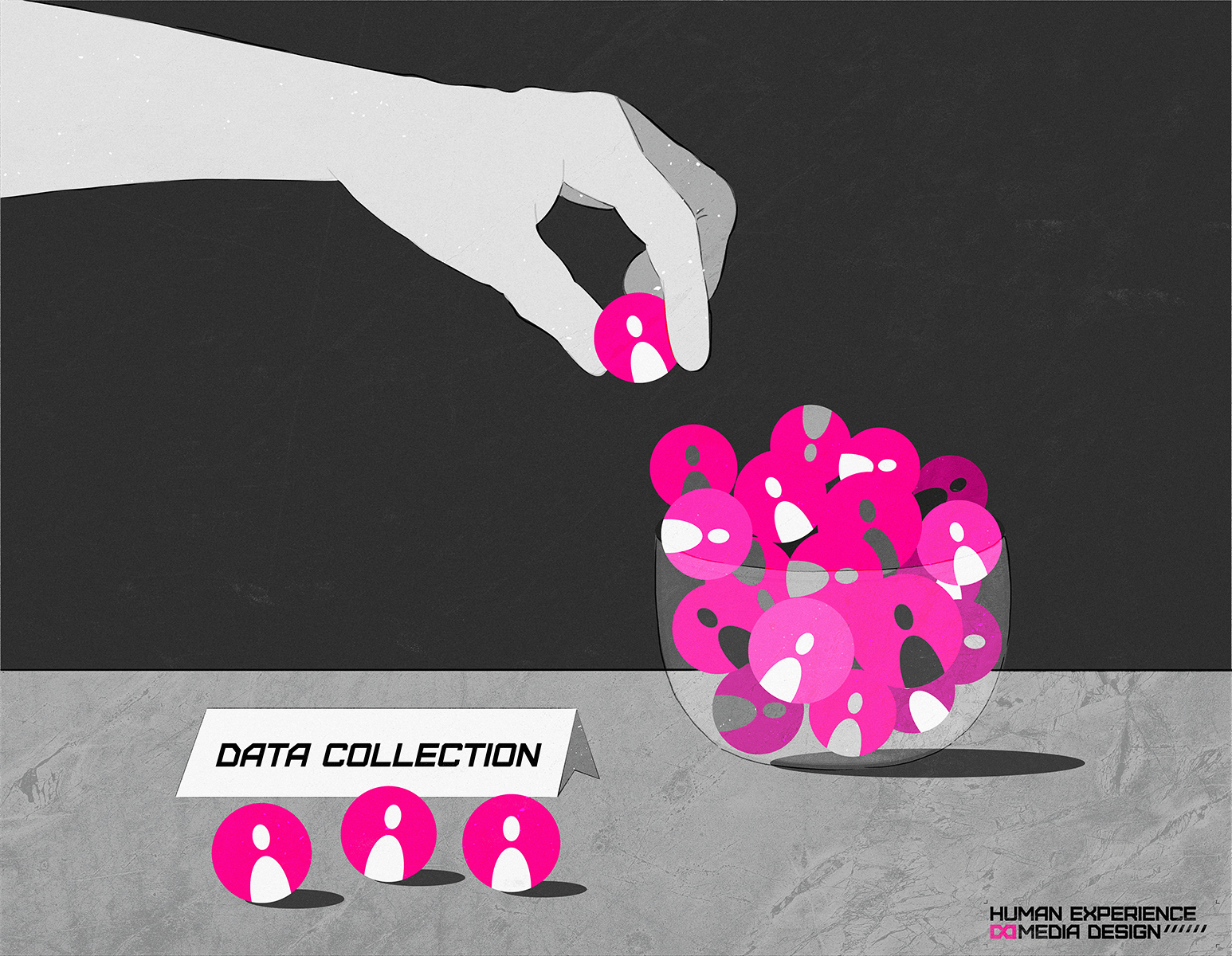

Hoewel technologie in sommige van deze contexten een tastbaar positief verschil kan maken, kan het vaak ook bepaalde groepen mensen benadelen. Niet alle technologie is ontworpen om inclusief te zijn en kan in het slechtste geval aanzienlijk negatieve effecten hebben op het leven van mensen. Huidige datagestuurde technologieën kunnen nieuwe ongelijkheden creëren of bestaande ongelijkheden verergeren.

Schadelijke effecten in de technologie

We spraken over de schadelijke effecten van technologie en data bias met dr. Cynthia Bennett, een postdoctoraal onderzoeker aan de Carnegie Mellon University in de Verenigde Staten. Dr. Bennett wijdt haar werk aan het vinden van antwoorden op moeilijke vragen over inclusie, gelijkheid en het uitbreiden van de toegang tot de voordelen van technologische ontwerpen met de nadruk op mensen met een handicap. Ze pleit sterk voor waarom we kritischer moeten nadenken over de impact van technologie en onze vooroordelen. Alleen dan kunnen we manieren vinden om te innoveren zonder schade aan te richten en de toegang tot de voordelen van technologie verruimen. Luister hieronder naar ons gesprek of lees onderstaande artikel in het Nederlands:

Beluister hieronder de podcast, lees verder voor de uitwerking van de Q and A

Kun je ons wat meer over jezelf en je werk vertellen?

Ik ben een postdoctoraal onderzoeker bij het Human-Computer-Interaction Instituut aan de Carnegie Mellon Universiteit en ik doe momenteel onderzoek op twee fronten. Ik ben geïnteresseerd in het vergroten van de deelname van mensen met een handicap in informatica en de technische industrie, dus ik kijk naar de processen en culturen die zijn ingebed in technologisch onderzoek en laat zien dat die ontwikkelingen meestal niet erg toegankelijk zijn.

We verwachten vaak dat mensen met een handicap alleen eindgebruikers van onze technologie zijn, maar niet per se de ontwerpers, ontwikkelaars en onderzoekers. Dat is dus een onderdeel van mijn onderzoeksprogramma: deze culturen beter begrijpen en de processen die we gebruiken veranderen om toegankelijker te zijn. Het tweede deel is meer een nieuwer en groeiend gebied en gaat over AI-bias en specifiek hoe het mensen met een handicap beïnvloedt.

Wanneer je de term ‘data bias’ hoort, waar denk je dan aan en hoe heeft het betrekking op je werk?

Data bias verwijst voor mij naar hoe data die we gebruiken, in dit geval om machine learning-modellen te trainen, mensen vertegenwoordigt en weerspiegelt die worden beïnvloed door de beslissingen die genomen worden op basis van die data en de algoritmen die die data gebruiken. Een manier waarop dit in mijn onderzoek naar voren komt is beeldbeschrijving. Blinde mensen kunnen vaak geen afbeeldingen zien en ze vertrouwen op tekstuele beschrijvingen van afbeeldingen die in die vorm van media moeten worden opgenomen. Ik ben bijvoorbeeld zelf een blind iemand, dus ik vertrouw daar ook op.

Machine learning wordt voorgesteld als een mogelijke oplossing. Wat zijn machine learning-modellen die overal automatisch beschrijvingen van afbeeldingen op het internet kunnen genereren? Dat zou een enorm probleem oplossen, omdat de meeste mensen geen beschrijving van hun afbeeldingen schrijven. Schrijf dus alsjeblieft beschrijvingen van je afbeeldingen op, want je menselijke beschrijving is veel beter dan die van een computer die niets weet over de context of sociale factoren. Ik heb gemerkt dat verschillende bedrijven en onderzoekers producten beginnen uit te brengen die deze automatische afbeeldingbeschrijvingen genereren.

Ook leer ik nu over onderzoek naar gender- en raciale vooroordelen bij AI, net als dat we niet veel weten over vooroordelen over handicaps bij AI. In een onderzoek dat ik vorig jaar deed, interviewde ik blinde mensen, dus mensen die baat hebben bij beeldbeschrijving, maar die ook een minderheidsgeslacht of ras zijn. Ik interviewde mensen die zich identificeren als niet-binair of transgender en die zich identificeren als zwart, inheems of een persoon van kleur. Zo ging het onder andere over de (mis)representatie van hen. Er zijn veel factoren die ertoe doen: relevante informatie, een beschrijving van een persoon of computer en of de machine bevestigbare details kent over hoe de persoon zich identificeert. De deelnemers hadden daarover veel zorgen. Enkele van de belangrijkste zorgen waren dat veel van de modellen, die worden gebruikt om het geslacht te identificeren, zijn getraind op gegevens die slechts twee geslachten kennen. Die vooringenomenheid en de manier waarop die modellen getraind worden kunnen mensen echt gekwetst laten voelen als hun gegevens verkeerd worden gebruikt.

Zijn er andere voorbeelden waar u ziet dat data bias mensen in gevaar brengt?

Een voorbeeld dat in de VS bijzonder relevant is, is het inhuren van tools en test-proctoringsoftware. Dit zijn tools die bedrijven en instellingen gebruiken om het besluitvormingsproces te automatiseren: is deze sollicitant gekwalificeerd? Vertonen ze kwaliteiten die we willen bij ons bedrijf? Het Centrum voor Democratie en Technologie heeft hierover een rapport geschreven en wat ons opviel is dat er niet eens rekening mee wordt gehouden dat iemand potentieel een handicap zou kunnen hebben. Dus misschien zijn sommige gedragingen zoals het niet kunnen maken van oogcontact – ik kan bijvoorbeeld geen oogcontact maken – een reden dat je als kandidaat lager zou kunnen scoren. Of als ik een testje doe en mijn ogen zijn niet op de camera gericht, denken mensen misschien dat ik niet geïnteresseerd ben. Dat kan gebeuren als je verkeerd wordt neergezet en dat kan zeer reële gevolgen hebben die we hebben gezien op het gebied van werkgelegenheid, onderwijs, huisvesting en gezondheidszorg.

Het kan dus een negatief verschil maken in hun leven. Ik vraag me af: waar komt het vandaan? Wat zijn de oorzaken van die bias?

Ik leer vooral van historici van wetenschap en ras. Simone Brown heeft een boek genaamd ‘Dark Matters’ waarin ze de bewaking van zwarte mensen in de VS traceert die teruggaat tot de slavernij. Dus als we deze geschiedenis hebben waar het zo ingebed is in onze cultuur dat het oké is om mensen te observeren en te onderzoeken op basis van hun ras, in dit geval zwarte mensen specifiek, dan wordt dat er ingeslepen en ingebouwd in onze systemen.

Het is een soort incarnatie, een volgende stap in onze geschiedenis en cultuur. We zien dit gebeuren in de VS, maar elke keer dat het systeem beslist waar de politie naartoe moet gaan, is dat gebaseerd op historische gegevens. We hebben al vastgesteld dat de gebieden waar zwarte en bruine mensen in de VS wonen, overbelast worden. Het heeft dus niets te maken met of het juist of onjuist is dat de politie ergens aanwezig is, het systeem is zo gebouwd. Als we deze problemen willen aanpakken, dan gaat niet alleen om het verzamelen van meer gegevens en het schrijven van verschillende algoritmen. Data bias en AI zijn slechts een herhaling van het classificeren van mensen. Dat gebeurt altijd al op een niet-technische manier.

Kunnen mensen zichzelf daartegen beschermen?

De oplossingen moeten vanuit instellingen komen. Wij individuen kunnen ons meer bewust zijn, maar we hebben zelf beperkte macht. We moeten samen sterk staan en instellingen hun collectieve macht laten gebruiken. Die verantwoordelijkheid is niet individueel, laat dat duidelijk zijn.

Waar moeten techmakers rekening mee houden voordat ze iets openbaar maken?

Een technische innovatie die zou kunnen helpen, maar ook beleid, is het mogelijk maken dat bepaalde technologie en bepaalde functies worden gebruikt door de mensen die ze nodig hebben. Zo wordt voorkomen dat die oplossingen worden gebruikt door mensen die ze kunnen exploiteren. Sommige van de oplossingen zullen voortkomen uit regelgeving en technische mogelijkheden, om te beperken wie over welke toegangen beschikt en om aanvaardbaar en onaanvaardbaar gebruik te reguleren.

De producties voor deze missie worden ondersteund door redacteur Aaron Golub

Bekijk hier andere items van deze missie:

Waarom data bias een lastig fenomeen is